整合发展:Mellanox的生态环境

时间:2011-07-07 02:17:00

来源:UltraLAB图形工作站方案网站

人气:26397

作者:admin

DOSTOR存储在线 4月19日原创报道: 去年11月,Mellanox公司宣布以2.18亿美元收购Voltaire公司,这在已经平静了很久的Infiniband市场可谓投下了一枚重磅炸弹——这是两家在Infiniband市场共同呼风唤雨的供应商——在人们认为市场早已归于平静、竞争走向鼎立与僵持的时候,Mellanox此举不仅说明其坚定的走在Infiniband市场的前沿的决心,更说明其在Infiniband市场获得了极为丰厚的利润。

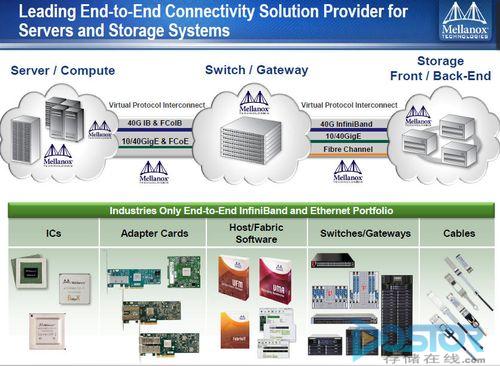

时间过去不到半年,Infiniband市场最大的供应商逐步浮出水面,随着对Voltaire公司的整合顺利完成,Mellanox公司成为Infiniband市场中当之无愧的领头雁,如今,这家以网络尤其是Infiniband网络成名及发展起来的公司,不仅拥有IC芯片、适配卡、软件和线缆产品,更拥有了补缺其整个产品生态环境的交换机及网关产品——从服务器、集群应用端,到存储前后端,以及中间的交换与网关——Mellanox形成了完整的Infiniband高性能连接生态环境。

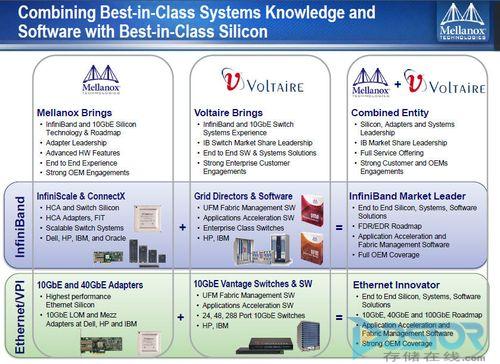

Mellanox与Voltaire的产品线融合情况

截止去年12月底,Mellanox在全球交付了超过700万个端口的产品,相较2009年的500万个端口增加了接近50%,Mellanox亚洲区技术总监宋庆春表示,在Voltaire公司的同事们加入之后,新的Mellanox将拥有超过700名员工——凭借双方研发力量的整合以及从硬件到软件的端到端解决方案——Mellanox如今开始进入更为广阔的市场:云计算和以太网。

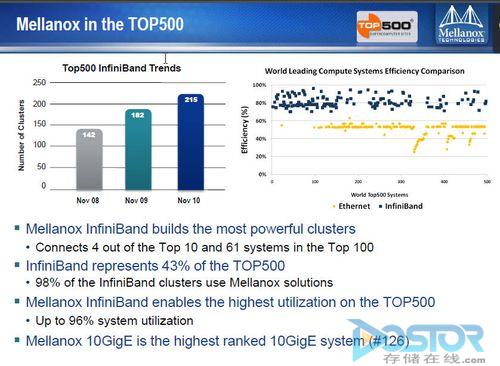

Mellanox亚洲区技术总监宋庆春在采访中向DOIT记者表示,他认为Infiniband仍然是业界追求高性能、高带宽及高效率、低功耗的典范式互联解决方案,随着Infiniband每端口的交付价格低于10GbE以太网,并提供更好的效率和性能,以及包括Mellanox在内提供的更好的来自于曾经的专有架构的管理套件,Infiniband仍然会是高性能计算、云计算、企业计算及存储的最佳互联解决方案。

整合发展:Mellanox的生态环境

据宋庆春透露,如果不包括Voltaire的营业收入,Mellanox在2010财年的营业收入达到了1.54亿美元,而这个数字很可能在2011财年被刷新——2011财年的第一季度Mellanox共收入5450万美元,这远远高于2010财年第四季度4070万美元的营业收入。

宋庆春表示,随着Voltaire的加入,这一收入将会继续增加。

正如前文所说,随着收购Voltaire的完成,Mellanox在高性能计算、云计算和企业计算及存储市场上获得了更为全面的能力,这甚至引发了Mellanox目前最知名的竞争对手之一QLogic的警觉,迫切的在市场上推出了针对Mellanox低端入门市场的Infiniband交换机产品。

“我们不太清楚我们的竞争对手在做什么,他们的产品从现在看可能是落后的,或者他们有自己的考虑,但这不会影响到Mellanox”在与宋庆春的交流中他表示,Mellanox对此并不是太关心,主要是这样的产品可能对市场竞争构不成太大的影响,现在Mellanox最重要的一点就是,除了原有的芯片、板卡、线缆和软件业务之外,Mellanox通过收购Voltaire获得了其Grid Director和软件业务。

Mellanox的产品线涵盖从软件到硬件的I/O连接端到端解决方案

在宋庆春展示的资料中可以看到,通过对Voltaire的收购,Mellanox获得了Infiniband和10GbE交换机及其相应的软件及系统产品,并彻底接管了Voltaire在Infiniband市场上的份额,形成了包括Infiniband+10GbE双网络的从硅芯片、软件到交换设备的生态系统。

“我们现在的OEM合作伙伴包括几乎所有的企业计算厂商。”宋庆春表示,随着Mellanox在Infiniband和10GbE双线产品家族的增长,包括惠普、IBM、Oracle和DELL等企业都是Mellanox的OEM合作伙伴,甚至在目前基于数据库机概念的产品市场上,Mellanox是唯一的Infiniband连接提供商。

除了Oracle推出的Exalogic和ExaDATA系统采用Mellanox的Infiniband解决方案之外,据宋庆春透露,目前IBM新推出的IBM DB2 pureScale数据库系统,同样采用了Infiniband高速连接,宋庆春认为,在未来数据库机系统广阔的市场前景下,Infiniband作为高速、低延迟及成本均衡的解决方案,会成为系统首选。

不过据宋庆春表示,未来在Mellanox的Infiniband新品、万兆产品等新产品中,开始都不再有Voltaire品牌,所有的产品都将以Mellanox名义出货。

进军I/O云:VPI成为技术核心

在本次会议上,宋庆春提到了Mellanox今后一段时间将重点发展的I/O云概念,通过这一概念,Mellanox将进入云计算市场,但在谈论I/O云之前,我们有必要先来看一下Mellanox所面向的市场的情况。

据宋庆春的介绍,Mellanox在云计算领域主要面向的市场是企业计算(服务器)、存储系统和少部分的嵌入式设备市场,在这个市场中,设备间的网络连接是位列三大需求之一的——包括计算能力、存储能力和网络连接能力——无论是LAN、SAN还是IPC I/O的需求,高带宽、低延迟的I/O是构建云计算环境中的IaaS(基础架构即服务)的核心价值点之一。

所有连接到云的设备或是相关技术,包括虚拟化、固态存储、基于高密度机架的应用程序、计算和存储刀片、系统整合、多核CPU和众核及GPU都被连接在一个拥有庞大I/O需求的闭环内,并由此形成云计算的基础架构即服务环境,从这个角度上来说,Infiniband、10GbE以太网和整合FC及以太网的FCoE是网络连接市场的重点。

Mellanox的IC提供40Gb/s IB(FCoIB)和40GbE (FCoE)的能力

结合到我们上文谈到的Mellanox的端到端生态环境不难发现,在整个I/O闭环内——刀片或嵌入式设备使用的适配卡、主机适配器、高性能的I/O网关、线缆、交换设备及软件,连接起来了这个I/O闭环的各个方面,而这也是Mellanox提出I/O云的基础。

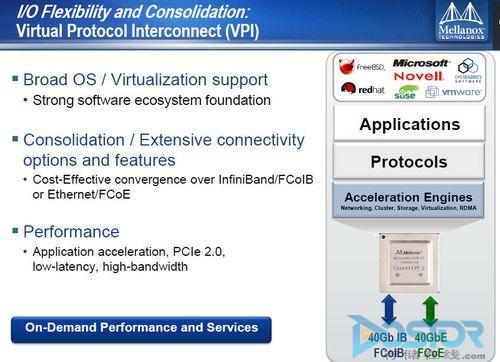

Infiniband的高带宽、低延迟的能力在此优势尽显,且成本已经降低到可以大规模使用并获得用户接受的程度——宋庆春说40Gb的Infiniband端口的价格与10GbE端口相比更低——随着今年56GB/s的FDR端到端解决方案的推出,以及Mellanox的VPI技术(Virtual Protocol Interconnect)的推广,Infiniband的优势会更加明显,“这是一项利用一个网络实现三个不同网络的工作的技术。”刘通表示。

“一个QDR端口可以虚拟多个以太网或FC端口,能够达到1.3μs的以太网延迟。”VPI技术将Infiniband网络虚拟成以太网或光纤通道网络并运行相应的协议,作为I/O云的基础,其提供了I/O层面的虚拟化:利用一个不变的物理网络,模拟多种网络连接,宋庆春表示,只有让用户统一了I/O,才能够让用户在不浪费成本的情况下——在数据中心内一台服务器往往要配置光纤HBA卡和NIC以太网卡,且必须是双冗余架构——才能够实现更具成本和性能表现的云架构。

据宋庆春介绍,已经有客户尝试将一个Infiniband卡虚拟出了16个HBA卡,将40Gb的带宽均分为16份,即使算上Infiniband卡双冗余架构,也要比16个2Gb FCHBA的成本效益和性能要高得多,即使是4Gb/s FC HBA应用环境,也有更好的性能和成本优势。

高性能计算前景广阔 行业协会助阵

与宋庆春一同接受采访的,还有国际高性能计算咨询委员会中国区总监刘通,他除了介绍国际高性能计算咨询委员会全球的发展情况,还提到了委员会面向全球高校发起的大学奖计划,而在将高性能计算和Mellanox的话题结合之后,我们又了解到了Mellanox在GPU加速计算方面的进展。

据刘通介绍,国际高性能计算咨询委员会目前在全球设有三个计算中心,包括美国加州、瑞士和中国的高性能计算中心,提供九个型号的高性能计算系统,每年,委员会都会开展一个名为“大学奖计划”的活动。

“每年我们通过这个计划支持大学进行HPC研究,资源、资金方面的帮助,提供好的环境,鼓励大学联合相关方面专家做研究。”刘通表示,国际高性能计算咨询委员会会为大学提供主流的HPC系统,只要有好的应用、计划或是项目都可以申请这个计划,获得三个计算中心的计算资源使用权,今年这个项目的截止日期是5月31日,刘通希望“能够有中国的院校参与进来。”

而谈到高性能计算,GPU加速的话题不免被提及,国际高性能计算咨询委员会也提供了GPU加速模式的HPC系统,而Mellanox如今利用GPUDirect技术及对自身Infiniband通信机制的改变,提供了更加符合GPU模式下的高性能计算通信机制。

在高性能计算领域,Infiniband与效率紧紧联系在一起

“GPU计算的效率都较低,这与通信机制有直接的关系,CPU、GPU、Infiniband卡的通信效率不高,CPU和GPU都去专属自己的一块系统内存,Infiniband要从CPU获得数据。”据宋庆春介绍,Mellanox在高性能计算领域,通过GPUDirect技术,让Infiniband拥有对系统内存的访问权。

无论是CPU的计算结果还是GPU的计算结果,都能够被Infiniband网卡直接读取,而不再需要CPU转储,通过Infiniband和CPU、GPU共享内存,提高了Amber运行速度33%。

据宋庆春表示,Mellanox基于Infiniband成熟的技术,会有更多针对通信存储的加速器,以及面向MPI应用的加速软件,与Infiniband GPU架构加速技术一起,提高高性能计算的通信和传输效率,在高性能计算领域,Infiniband会一直是“最好的传输解决技术”。